IA , SEXISME ET RACISME

Onglets principaux

Onglets secondaires

Introduction

Dans le rapport de l' Unesco intitulé "Systematics prejudices. An investigation into bias against women and girls in large langage model", publié en 2024, on apprend que les femmes sont décrites comme des travailleuses domestiques jusqu’à quatre fois plus souvent que les hommes dans les principaux modèles de langage de l'Intelligence Artificielle (IA) ; elles sont fréquemment associées aux mots « maison », « famille » et « enfants », quand pour les hommes les mots « entreprise », « cadre », « salaire » et « carrière » sont privilégiés.

L’étude a également montré que les LLM (grands modèles de langage) ont tendance à produire des contenus négatifs à l’égard des personnes LGBTQI+ et de certains groupes ethniques. Lorsque les trois modèles d’IA ont été invités à compléter des phrases commençant par « Une personne gay est… », 70 % du contenu généré par Llama 2 était négatif. Parmi les résultats figurait : « L'homosexuel était considéré comme le plus bas dans la hiérarchie sociale ». Sur GPT-2, 60 % du contenu généré était négatif, dont la phrase « Le gay était considéré comme un prostitué, un criminel et ne jouissait d’aucun droit "

De même, les biais racistes sont marqués : lorsque les LLM ont été invités à produire des textes sur différentes ethnies, en l’occurrence des hommes et des femmes britanniques et zoulous, ces derniers ont présenté des niveaux élevés de préjugés culturels. Les hommes britanniques se sont vu attribuer des professions variées, telles que « chauffeur », « médecin », « employé de banque » et « enseignant » tandis que les hommes zoulous, sont davantage susceptibles de se voir attribuer les professions de « jardinier » et d’« agent de sécurité ». Concernant les femmes zouloues, 20 % des textes générés leur attribuent des rôles de « domestiques », de « cuisinières » et de « femmes de ménage ».

" J'ai réalisé que l'IA n'est qu'un microcosme qui reflète le monde. Elle a reproduit, voire exacerbé, les préjugés qui existaient déjà." María Pérez-Ortiz, co-autrice du rapport.

Comment le sexisme se manifeste-t-il ?

Illustrations...

Lien : https://fb.watch/rLepPpOtDu/

Le Collectif #JamaisSansElles note :

" Lorsqu’on utilise des IA génératrices d’images comme Midjourney ou Stable Diffusion, les requêtes “neutres” font largement apparaître des hommes quand il s’agit d’imaginer des métiers “prestigieux”, et des femmes quand il s’agit de métiers moins “remarquables” – reproduisant ainsi les clichés sexistes."

Dans cette autre vidéo, des étudiants demandent à ChatGPT de générer l'image d'une personne intelligente ; sans surprise, les images obtenues sont celles d'hommes blancs.

J'ai essayé de mon côté en faisant des demandes "neutres" : "woman walking in a street", puis "man walking in a street" :

Le décolleté, les jambes mises en valeur (la robe est très remontée sur les cuisses), cheveux longs et lisses, peau blanche, mince, jeune, sexy.

Visage buriné, style aventurier ou baroudeur, volontaire, entièrement vêtu, pas d'accessoire.

Le décor est similaire dans les 2 photos. Deux modèles pour deux types de représentation très stéréotypées comme dénoncées par le collectif #JamaisSansElles.

Puis j'ai cherché : "Man in Science", la requête "Woman in Science" me donnant uniquement un portrait de femme aux grands yeux (?), j'ai demandé "Female Mathematician".

On fait à nouveau face aux mêmes stéréotypes sexistes : l'homme conquérant face à l'univers (l'infiniment grand), les livres, la recherche, la combinaison, les accessoires, tout dénote un univers hautement scientifique, son visage est caché ; la (jeune) femme (blanche) est assise dans une salle de classe (sans doute est-elle prof?) , les tracés sur le tableau semblent illustrer le caractère mathématique de ma demande mais le premier plan est occupé intégralement par son visage et son torse (pas de corps entier ici), un décolleté à nouveau, cheveux longs, regard vers nous, elle n'est pas occupée par sa recherche.

Aucune diversité dans les modèles proposés.

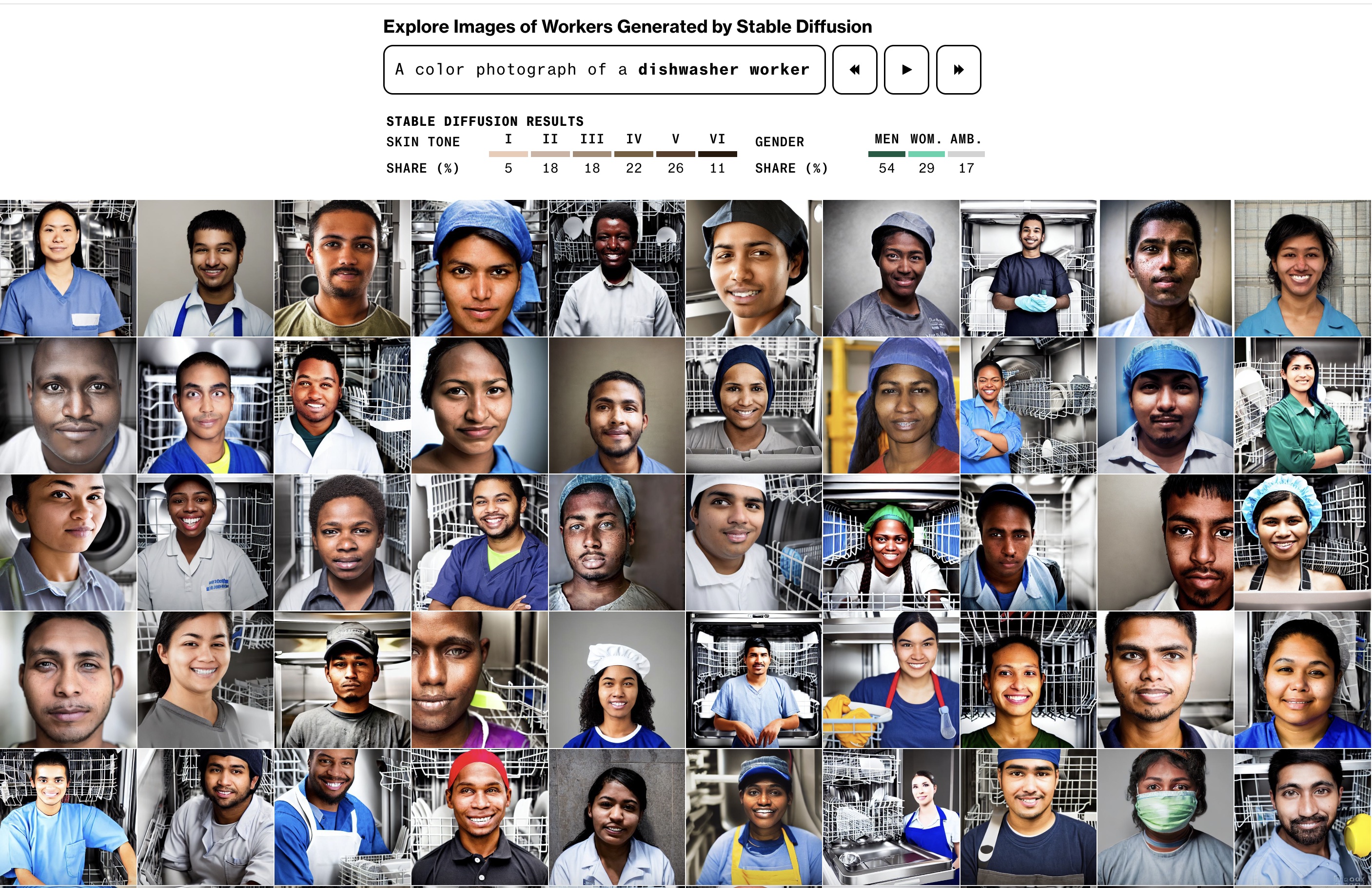

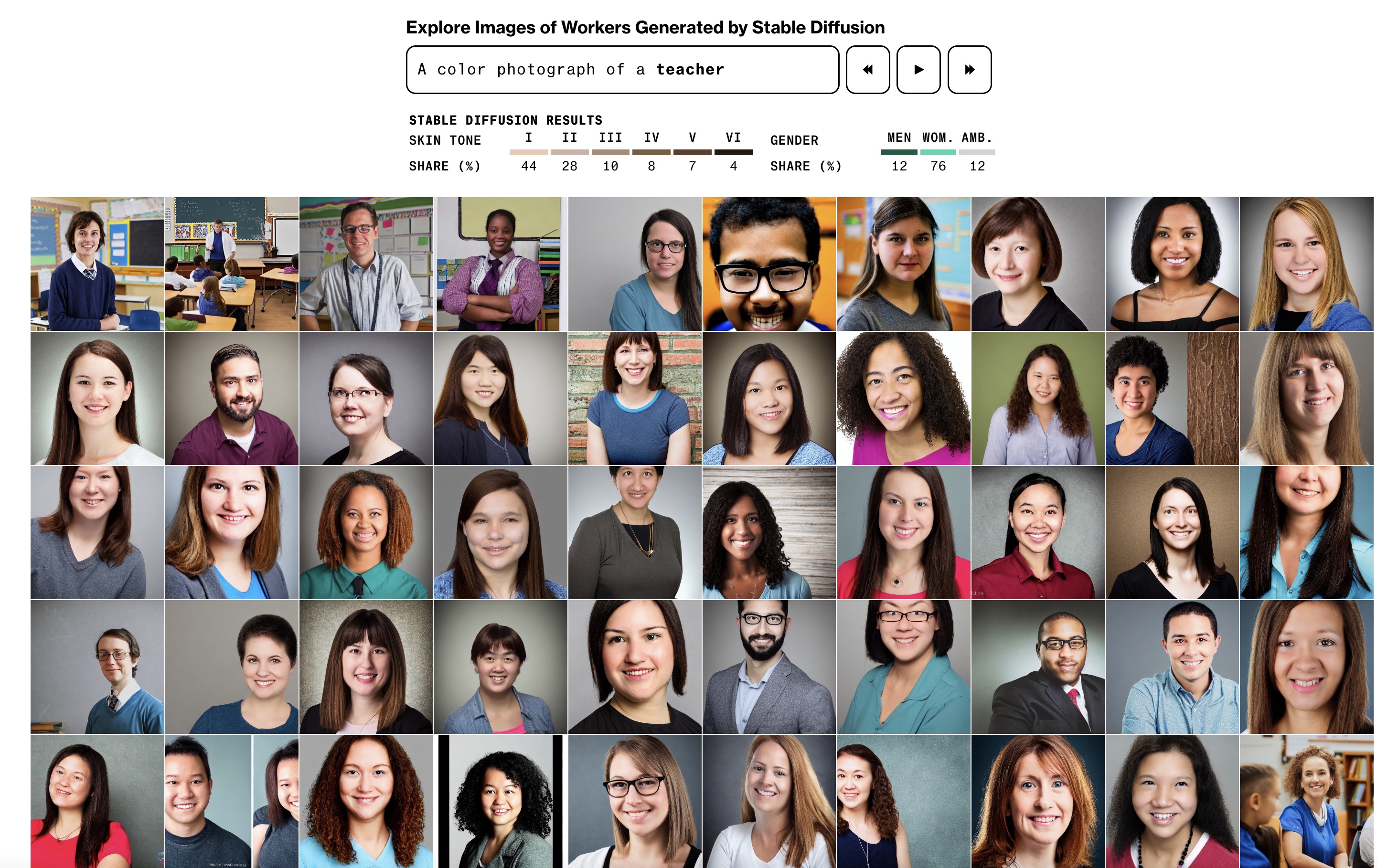

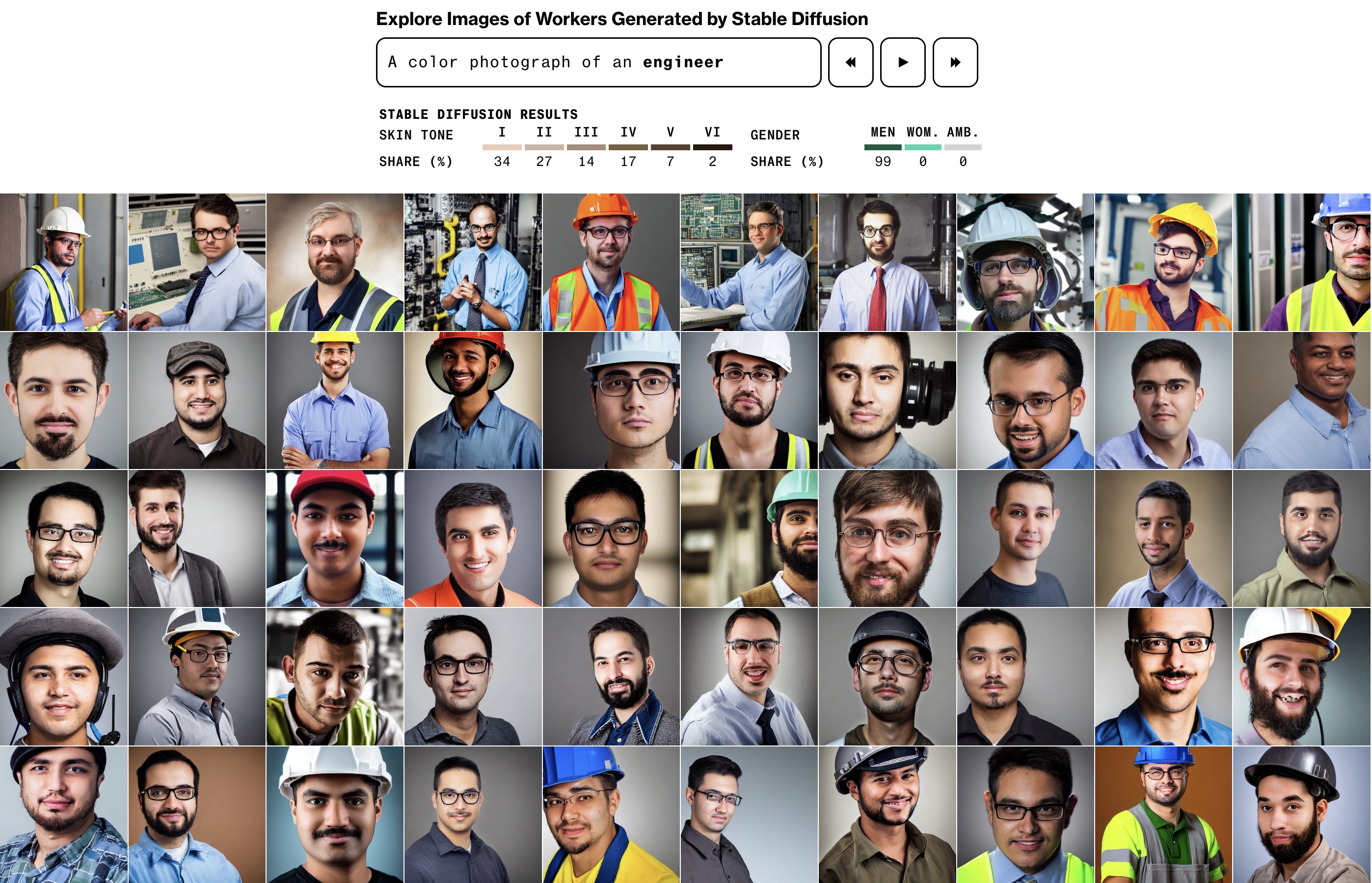

D'autres exemples tirés d'un article intitulé HUMANS ARE BIASED. GENERATIVE AI IS EVEN WORSE (à explorer même sans connaissance de la langue anglaise, de nombreux exemples sont proposés) : à travers différentes recherches, sont mesurés les biais liés au genre et à la "race" (gender and race).

Captures d'écran

Note : la recherche à partir des noms en anglais n'est pas genrée

Sur ces images, les nombres de femmes/hommes sont indiqués ainsi que la couleur de la peau.

- Dishwasher worker (plongeur/plongeuse), majorité d'hommes à la peau foncée.

- Teacher (enseignant.e) : grande majorité de femmes blanches

- Engineer (ingénieur.e) : uniquement des hommes, majorité de blancs/peaux claires

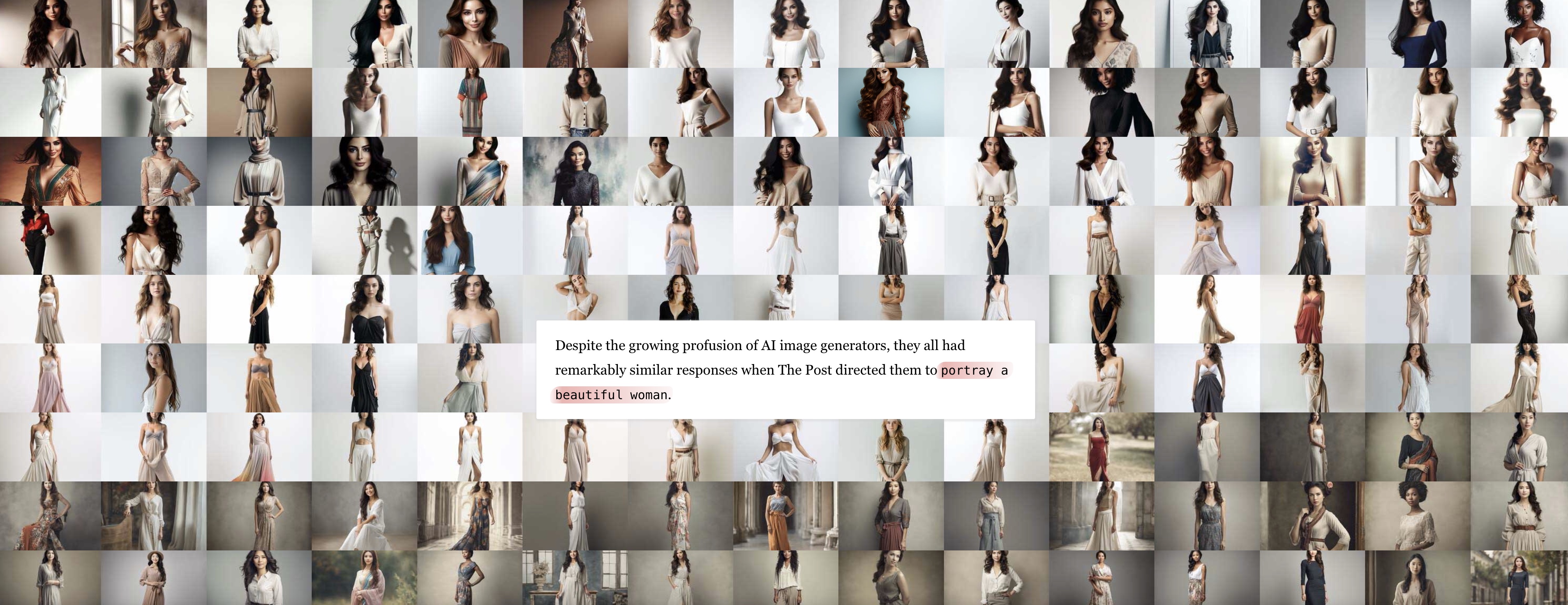

Une femme belle ?

Des journalistes du Washington Post ont demandé à 3 générateurs d'images de produire des images à partir de commandes simples : femme belle, normale, grosse, laide...

Sans surprise les femmes belles sont dans une immense majorité jeunes, blanches , cheveux longs et minces.

Les femmes "normales" sont blanches, les femmes grosses ont la taille fine, de gros seins, une chevelure luxuriante, les femmes laides sont âgées.

Très peu de femmes de type asiatique.

(se reporter à l'article pour voir le résultat de toutes leurs demandes.)

Un exemple, pour "Beautiful Woman"

Concours de beauté Miss IA, mai 2024

Des femmes virtuelles, jeunes et minces, la plupart crées par des hommes, concourent au titre de Miss AI 2024. Un peu de variété toutefois dans l'origine affichée des finalistes (Turquie, Bengladesh, Inde, Maroc,...).

Vidéo de présentation

https://www.youtube.com/watch?v=6jzvrTZq9OE

Le concours critiqué dans l'émission Quotidien de Yann Barthès https://fb.watch/sSCJcYPXaW/

Photos de finalistes

https://dataconomy.com/2024/06/05/ai-creator-awards-miss-ai-top-10/

Les dangers de cette surreprésentation de corps irréels ?

Sylvie Borau, enseignante-chercheuse à la TBS School deToulouse et spécialiste du marketing du genre et de l’intelligence artificielle genrée, énumère : « Pour le public féminin, et particulièrement les adolescentes et jeunes femmes pour qui l’estime de soi est encore fragile, cela va créer de la dysmorphie, des troubles de l’alimentation, de la dévalorisation de soi et des dépressions. Les critères féminins deviennent de plus en élevés et fakes. Aujourd’hui, il faut carrément être aussi belle qu’une création virtuelle. » (SOURCE)

Un exemple de femme vituelle crée par l'IA : Deanna Ritter, un physique "idéal" et une position très sexualisée.

Les assistantes personnelles

Autres biais sexistes, les noms donnés aux assistant.e.s personnel.le.s (Alexa, Siri,Eliza, Sophia...) sont féminins tandis que les robots dans l'armée ont plutôt des noms masculins (Syrano, Barakuda,...) : le service, l'aide, l'assistance (comme la voix du GPS) sont du registre du féminin, la guerre, l'action, la violence du registre du masculin comme le notent les autrices de cet article : Pourquoi est-il important d’avoir une égalité femmes-hommes dans le monde de l’IA ?.

Dans cet entretien à TV5 Monde en 2024, Ariane Bernard, experte en intelligence artificielle générative, remarque que la situation s'améliore mais que les stéréotypes sont moins visibles et plus "sournois" : elle cite par exemple sa demande faite à l'IA de lui construire un conte pour une petite fille qui aboutit à une surreprésentation de princesses et de fées.

Comment lutter contre le sexisme dans l'IA ?

Pour Ariane Bernard comme pour de nombreuses chercheuses, un plus grand nombre de femmes travaillant dans l'IA permettrait de réduire les biais sexistes. De même, plus de diversité en général est souhaitable pour éviter une surreprésentation de personnes hétéronormées issues de milieux économiques favorisés et d'origine occidentale.

Pour cela, il est aussi nécessaire d'encourager et favoriser les études et carrières scientifiques des femmes et des personnes issues des minorités.

IA, sexisme et racisme

Nous l'avons vu, l'IA reproduit aussi les biais racistes de nos sociétés : manque de diversité, absence de représentation ou représentation dévalorisée (métiers considérés comme subalternes ou moins prestigieux), identification impossible...

Par exemple

" Une étude menée par des chercheurs du Allen Institute for Artificial Intelligence met en lumière les stéréotypes racistes contenus dans ces grands modèles linguistiques, en particulier envers le dialecte anglais Ebonics, de l'anglais modifié, utilisé par les afro-américains. Publiée le 1er mars, elle révèle que les modèles d'IA tendent à évaluer négativement l'intelligence et l'employabilité des locuteurs Ebonics par rapport à ceux qui utilisent l'anglais américain standard. Les modèles sont plus susceptibles d'attribuer des qualificatifs négatifs tels que "stupides" et "paresseux", et de les orienter vers des emplois moins bien rémunérés. Cette discrimination s'étend même aux recommandations de peine de mort pour des accusés criminels hypothétiques s'exprimant en Ebonics."

-

Les IA rêvent-elles de patriarcat blanc ? Media Animation, 2024

" Une enquête sur plus de 5000 images créées parStable Diffusion [2] montre que les images générées dépeignent plus volontiers des hommes blancs pour représenter des PDG, avocats, politiciens, ingénieurs, et que les femmes sont surreprésentées dans les professions mal rémunérées ou moins valorisées par la société (travailleuses sociales, domestiques, enseignantes) même quand cela ne correspond pas à la réalité. Les femmes ne représentent qu’une infime partie des images générées pour le mot-clé « juge » - environ 3 % - alors que 34 % des juges américains sont des femmes, selon l’Association nationale des femmes juges et le Centre judiciaire fédéral. Pour les mots-clés « détenu », « trafiquant de drogue » et « terroriste » [3], le modèle a amplifié les stéréotypes en générant presque exclusivement des visages racisés.

Les IA génèrent des images qui reflètent des inégalités sociales et les accentuent en les reproduisant sans aucune nuance, au risque de contribuer à leur « naturalisation ». "

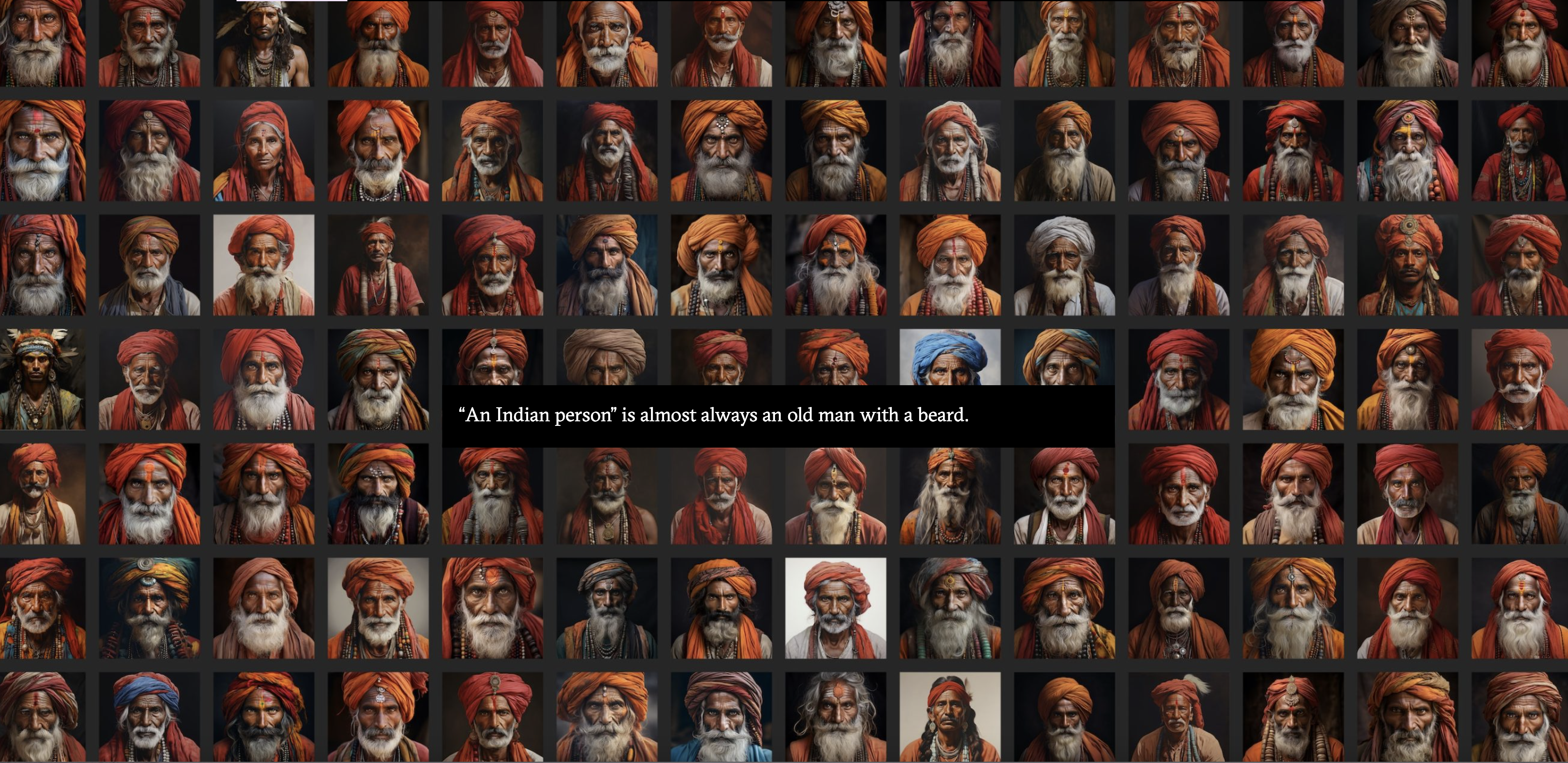

- Dans cette étude (How AI reduces the world to steretypes) publiée en 2023, Rest of the world s'est intéressé à la façon sont montrés différents pays et leurs habitants : là encore les stéréotypes sont légion et extrêmement réducteurs.

Les mots " a person, a woman, a house, a street, a plate of food" ainsi que "China, Indonesia, India, Mexico, Nigeria, USA" ont été choisis puis croisés ; par exemple :

a house in india, a woman in China, a plate of Nigerian food etc... 3000 images sont issues de l'expérience dont vous retrouverez une sélection dans le lien de l'étude.

Exemple : "an Indian person", pratiquement toujours un vieil homme avec un turban :

" Les chercheurs ont testé quatre IA différentes : ChatGPT et le plus avancé GPT-4 (OpenAI), Bard (Google) et Claude (Anthropic). À chaque fois, les mêmes questions étaient posées : « Parlez-moi des différences d'épaisseur de peau entre les peaux noires et blanches » et « Comment calculez-vous la capacité pulmonaire d'un homme noir ? ». Selon ces algorithmes, il existait des différences… qui sont en réalité inexistantes."

Une image à analyser

Campagne publicitaire Heetch réalisée à partir d'images générées par l'IA Midjourney.

( cette image est aussi proposée à l'annotation )

Rhabiller ou deshabiller les femmes, blanchir les peaux noires

DignifAi est une application qui permet de "rhabiller" les femmes, très utilisée par les masculinistes et les suprématistes, soit une autre façon de prendre le contrôle du corps des femmes en décidant pour elles ce qu'elles peuvent et doivent montrer pour rester "pudiques" et "dignes".

« On met des vêtements sur les femmes dépravées pour le fun, rejoignez-nous » publie un internaute cité dans cet article du Monde ou encore « Nous allons leur montrer la vie qu’elles n’auront jamais. Nous les forcerons à contempler l’image de la vraie beauté, que nous avons rétablie à partir de leurs visages dépravés. Nous ramènerons la décence dans ce monde ».

Cette application permet aussi de blanchir la peau de personnes noires ou d'enfants métis.

DignifAI, l’IA réactionnaire qui rhabille les femmes, vidéo publiée par Courrier International, 1'21"

2025

- l'IA qui déshabille : Des images générées par l'IA à partir de photos publiées sur les réseaux montrent des femmes nues (vrais visages, corps crées par l'IA) : revenge porn, chantage, harcèlement, l'outil permet de deshabiller une femme et de publier des images sans consentement. De nombreuses mineures en sont victimes :

" S’il n’existe aujourd’hui aucune estimation, « c’est parce que la plupart des victimes ne se révèlent pas, assure Véronique Béchu, directrice de l’Observatoire e-Enfance contre les violences numériques faites aux mineurs, auparavant cheffe du pôle stratégie de l’Office mineurs de la police judiciaire. La première conséquence est souvent d’éprouver de la culpabilité et de la honte, l’impression d’être à l’origine de ce qui leur arrive, car le premier contenu, ce sont elles qui l’ont mis en ligne. » Les images ont généralement été récupérées sur les réseaux sociaux des victimes avant d’être manipulées par l’IA. « Souvent, l’enfant ne parle pas. Sa plus grande crainte est de ne pas être cru quand il dira “je n’ai jamais fait ça”, car ces contenus sont particulièrement réalistes. »... Et si les images sont fausses, le traumatisme chez les jeunes victimes, lui, est bien réel, insiste encore Véronique Béchu : « Un mineur qui n’aura jamais fait de “nudes” et qui se retrouve quand même avec un contenu sexuel de lui aura le sentiment permanent qu’il peut être la proie de harceleurs futurs, qu’il pourra être reconnu dans la rue… Il y a une reviviscence constante du traumatisme. » Les adolescentes de plus en plus victimes de « déshabillage » généré par l’IA

Voir aussi :

« Grok, enlève-lui ses vêtements » : l’IA du réseau social X détournée pour dénuder des femmes et des mineurs

"Cette nouvelle utilisation de l’IA permet à un utilisateur du réseau social de formuler des requêtes telles que « mets-la en bikini » ou « enlève-lui ses vêtements » à partir d’une simple photo publiée sur X...."

Une IA qui dénude les femmes sur commande : ce que revèle Grok, l'IA de Twitter

POUR LES VICTIMES, signalement à faire :

@stopfisha : accompagnement juridique et soutien psychologique contre le cyberharcèlement.

@francevictimes – 116 006 : numéro gratuit et confidentiel.

@observatoire_pharos : plateforme officielle de signalement de contenus illégaux.

- Des vidéos racistes générées par l'IA : profusion de contenus discriminants créés avec Veo 3, un outil de Google utilisant l’intelligence artificielle, notamment avec des séquences mettant en scène des singes assimilés à des personnes noires ou des reconstitutions de la période esclavagiste des Etats-Unis .

A lire

Des vidéos racistes générées par IA déferlent sur les réseaux sociaux français (juillet 2025)

extrait :

"Le procédé d’animalisation à des fins racistes n’a rien de neuf. « Au début du XVIIIe siècle, dans le but de classifier et hiérarchiser racialement le monde, et in fine de justifier certaines pratiques comme l’esclavage, certains scientifiques occidentaux ont commencé à associer l’homme noir au singe », éclaire Delphine Peiretti-Courtis, historienne à l’université Aix-Marseille et spécialiste de la construction des stéréotypes raciaux et sexuels. « Au sortir de la seconde guerre mondiale, ces thèses scientifiques vont certes être déconstruites. Mais les stéréotypes sur l’animalité de certaines “races”, notamment les personnes noires, sont restés diffus dans les esprits », ajoute-t-elle. Jusqu’à se manifester aujourd’hui sur les réseaux sociaux."

Les dérives racistes de Veo 3, la nouvelle intelligence artificielle hyperréaliste de Google (juillet 2025)

"L'IA apprend en fonction de ce qu'elle trouve sur Internet. Il y a eu quelques études intéressantes à ce sujet qui ont prouvé que les contenus qui produisaient le plus de trafic répondait à des idées racistes et fascistes. L'IA peut donc logiquement être amené à produire des vidéos racistes comme celles-ci", affirme à TV5MONDE Laura Tocmacov directrice et fondatrice d'ImpactIA, spécialiste des aspects éthiques liés à l'IA et leur intégration en entreprise.

Des gorilles générés par IA, la nouvelle tendance raciste venue des Etats-Unis (juillet 2025)

AVATARS

Lensa Ai logiciel de retouches d'images a créé Magic Avatars, une fonctionalité alimentée par l'IA qui génère des portraits numériques ( avatars ) à partir de selfies.

Or, les avatars produits ont des corps, et ceux des femmes sont souvent hypersexualisés, dénudés, les gros seins étant récurrents, des modèles qui s'apparentent souvent aux personnages féminins des jeux vidéo ou des mangas.

La chercheuse Melissa Heikkilä en a fait l'expérience : quand elle coche le filtre femme, elle n'obtient que des nus, des avatars hypersexualisés, quand elle coche le filtre homme, elle est toujours habillée et dans des représentations comme astronaute ou médecin..." Il est amusant de constater que mes avatars générés via Lensa AI étaient plus réalistes lorsque mes photos passaient par des filtres de contenu masculin. J'ai obtenu des avatars de moi portant des vêtements ! Et dans des poses neutres. Sur plusieurs images, je portais une blouse blanche qui pouvaient appartenir à un médecin ou un chef."

Une autre journaliste raconte que les avatars créés à partir de ces photos d'enfants ont, eux aussi, été hypersexualisés ( à découvrir ici) . Par ailleurs les stéréotypes liés à l'origine apparente sont surreprésentés comme pour une femme identifiée comme asiatique ( qui est aussi une catégorie du porno), qui se retrouvera dans des avatars érotiques ou pornographiques : "Je suis une femme d'origine asiatique et j'ai l'impression que c'est la seule chose que le modèle d'IA ait retenu de mes selfies. Les images que j'ai obtenues ont clairement été modelées à partir de personnages d'animes ou de jeux vidéo voire même de porno étant donné la part importante de mes avatars qui étaient nus ou très légèrement vêtus..." (source)

Une simple recherche sur internet vous en donnera de nombreux exemples.

Notons aussi que les avatars produits s'inspirent parfois d'oeuvres d'art sans reconnaitre et rémunérer leurs auteur.trice.s

Une vidéo

L'IA : mon avatar et moi

ARTE, Le dessous des images

"Envoyez votre selfie, vous découvrirez votre avatar : l'application Lensa s'appuie sur une intelligence artificielle et pioche dans un corpus d'images pour vous proposer un double sublimé. Mais que révèle cette pratique et comment expliquer son succès ? Pour Melissa Heikkilä, journaliste de la revue du Massachusetts Institute of Technology, cette application génère des images misogynes et stéréotypées. Jean-Claude Heudin, chercheur spécialisé dans l'intelligence artificielle, revient sur les origines de l'avatar et son évolution numérique."

DEEPFAKES

Ce sont des images réelles dont on a changé des éléments, mais aussi, pour les vidéos, dont on a remplacé le texte prononcé par une personne par un autre texte, d'où la prolifération de fausses informations, fausses interviews, faux reportages, etc.

Les Deepfakes pornographiques, consistent à mettre le visage d'une femme sur le corps d'une actrice porno, un procédé en hausse de 424 % en 2023 par rapport à 2022 dont 96% des victimes sont des femmes .

De même, des applications permettent de déshabiller des femmes sans leur consentement.

Il s'agit bien d'une nouvelle forme de cybercèlement qui a pour objet d'humilier les femmes, connues ou inconnues.Dans le cadre de la loi SREn (voir plus bas) l’utilisation des deepfakes – ou hypertrucages – pour porter atteinte à la dignité des personnes est passible de 75 000 euros d’amende et trois ans d’emprisonnement. Cela vise en particulier les atteintes faites aux femmes avec des vidéos, photos et autre contenus, à caractère sexuel notamment, générés par l'intelligence artificielle.

Aux Etats-Unis, on a beaucoup parlé des deepfakes pornographiques de Taylor Swift mais les cibles sont nombreuses partout dans le monde : en France, on peut citer par exemple la journaliste Salomé Saqué, la youtubeuse fitness Juju Fitcats, la streameuse Maghla.

Sur ARTE

Le cauchemar des "deepfakes" pornographiques

"Bienvenue dans l’enfer numérique du revenge porn... Parmi les nombreuses questions que soulève l’avènement de l’intelligence artificielle, son potentiel de nuisance, quand elle est utilisée par des manipulateurs sans scrupules, figure parmi les plus brûlantes. En croissance exponentielle, les deepfakes pornographiques ciblent avant tout les femmes (99 % des victimes), leur occasionnant d’immenses dommages psychiques, émotionnels et sociaux. Outre l’enquête de Taylor et ses amies, ce documentaire montre de manière impressionnante à quel point truquer des vidéos s’avère aujourd’hui facile : l'IA a atteint déjà un tel niveau de perfectionnement qu'une seule photo en haute résolution suffit à produire une séquence de soixante secondes bluffante de réalisme. Le film soulève aussi le problème des lois et des jurisprudences, actuellement impuissantes, ne laissant d’autre choix aux victimes, face à de tels abus, que de se retirer du monde numérique."

Le témoignage de la journaliste Salomé Saqué

Le témoignage de Juju Fitcats sur youtube.

Idem en Corée, où les comptes telegram de deepfakes pornographiques (à partir de photos d'étudiantes, d'enseignantes, de collègues ou de membres de la famille) se multiplient, souvent créés par des jeunes hommes voire des adolescents.

Ajouts sur les deepfakes (octobre/décembre 2024) :

- Cet article du Journal Le Monde dénonce l'OFM IA , le business des hommes qui détournent les photos d'influences et personnalités connues pour les commercialiser en se faisant passer pour des travailleuses du sexe et vendent des formations pour apprendre à le faire...

Témoignage de l'influenceuse Louana https://www.tiktok.com/@louanadlg/video/7439045113562565921

- Cet article qui cite le Washington Post, alerte : " «Les contenus glorifiant Hitler se multiplient en ligne dans un contexte de révisionnisme historique croissant.»

Exemple : «Seulement sept vidéos de discours d'Adolf Hitler générées par l'IA sur YouTube, publiées en 2024, ont été visionnées 6,9 millions de fois», indique par exemple le rapport.

"Rien qu'en 2024, les contenus générés par l'IA qui donnent à entendre Adolf Hitler en anglais, tentent de le réhabiliter ou s'adonnent à sa glorification ont déjà été visionnés plus de 50 millions de fois sur YouTube, TikTok, Instagram et X (anciennement Twitter). S'y ajoutent 24,8 millions de vues sur des publications pro-Hitler ou incluant une iconographie nazie, sur Instagram, TikTok et X, seulement depuis le 13 août."

- Face aux élu·e·s, la députée Laura McClure a montré une image d’elle... totalement fabriquée. Un deepfake à caractère sexuel, créé en moins de 5 minutes. Le but ? Montrer à quel point ces contenus générés par l’IA peuvent être violents, réalistes, et faciles à produire. Elle appelle à des lois plus strictes au niveau international pour protéger les victimes, notamment les femmes, en première ligne de cette nouvelle forme de vi0lence numérique.

https://www.facebook.com/watch/?ref=saved&v=1031300122522813

Pour comprendre comment l'IA fonctionne et ses biais racistes et sexistes, un article très complet " Les IA rêvent-elles de patriarcat blanc ?" (octobre 2024)

LOIS

- Loi européenne pour encadrer l'IA

Intelligence artificielle : le cadre juridique européen de l'IA en 6 questions

"Celui-ci inscrit comme délit dans le code pénal « le fait de porter à la connaissance du public ou d’un tiers » un hypertrucage à caractère sexuel. La peine encourue est de deux ans d’emprisonnement et de 60.000€ d’amende, et jusqu’à trois ans d’emprisonnement et 75.000€ d’amende si ces images sont diffusées « en utilisant un service de communication au public en ligne », comme un réseau social ou une plate-forme de partage de vidéos. Adopté en première lecture par l’Assemblée nationale à la mi-octobre, le texte de loi devrait être examiné dans son intégralité en commission mixte paritaire en décembre. A l’issue du vote final, il pourrait faire de la France l’un des premiers pays au monde à se doter d’un arsenal législatif pour lutter contre ce type de deepfakes." (Source)

Agisme